Kubernetes中的CPU Burst机制:容器性能调优指南

Kubernetes中的CPU Burst机制:容器性能调优指南

在我的工作经历里,多次进行了容器化应用在Kubernetes部署环境的性能诊断与优化,本文是对 CPU Burst在应对容器化应用的 CPU 节流问题的技术总结。

1. 概述

本文档详细介绍Kubernetes环境中的CPU Burst功能,这是一种能够有效缓解容器CPU节流问题、提升应用性能的关键技术。在多线程、高并发和对延迟敏感的工作负载中,CPU Burst可以显著改善服务质量,降低响应时延,提高资源利用率。

2. 问题背景

2.1 K8S资源限制与CFS调度

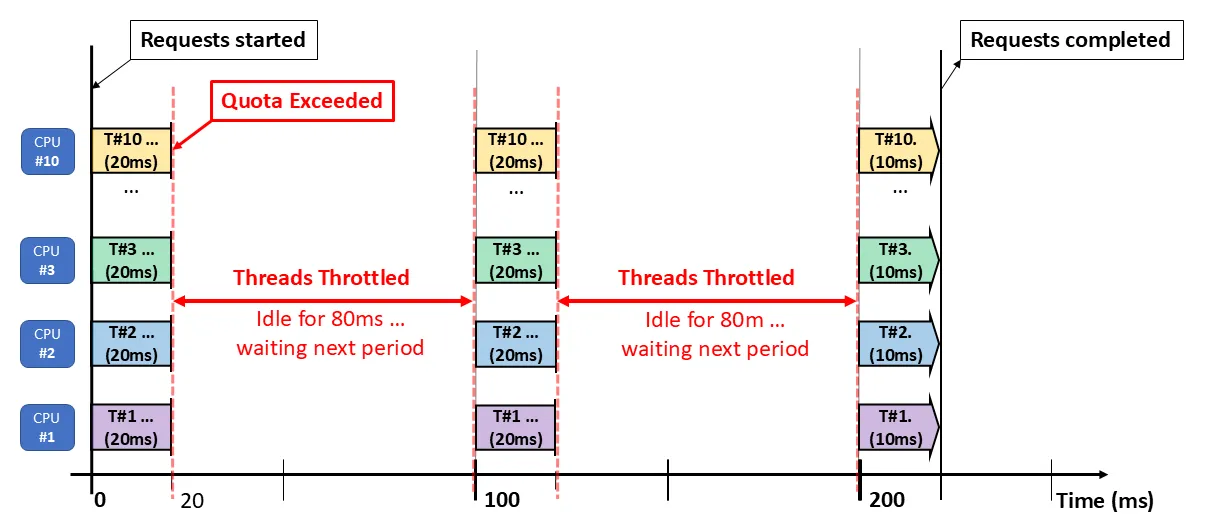

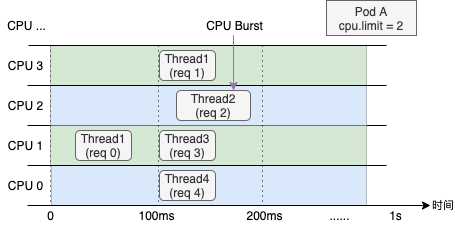

Kubernetes使用Linux内核的完全公平调度器(CFS)实现CPU资源限制。默认情况下,CFS在100毫秒的周期(cfs_period_us)内强制执行容器的CPU配额(cfs_quota_us)。当容器在一个周期内用尽配额时,所有进程将被节流(Throttled)直到下一个周期开始。

2.2 CPU节流导致的性能问题

如上图所示,即使容器的平均CPU使用率远低于其限制,容器依然可能因短时间内的高CPU使用而被节流。这会导致:

- 请求响应时间延长(RTT增加)

- 活性探测失败导致容器重启

- 微服务调用链超时

- 垃圾回收停顿延长

- 网络连接中断

2.3 多线程应用的特殊挑战

多线程应用在CFS调度器下面临更严重的问题:

以10个线程并行运行在2核CPU限制的场景为例:

- 每个线程在独立核心上运行时,第一个20毫秒就累计消耗200毫秒CPU时间

- 超出配额后,所有线程被同时节流80毫秒

- 任务完成时间从理想的50毫秒延长到210毫秒(性能下降76%)

3. CPU Burst功能介绍

3.1 工作原理

CPU Burst功能能够动态感知CPU节流现象并对容器参数进行自适应调节。它通过以下机制工作:

- 积累未使用的CPU时间片:在低负载时,容器可以"存储"未用完的CPU时间配额

- 动态调整CFS参数:根据容器的历史CPU使用模式调整cgroup参数

- 弹性资源分配:在负载高峰期临时提供额外CPU资源

3.2 核心技术指标

CPU Burst主要通过调整以下cgroup参数实现:

cpu.cfs_quota_us:容器在一个周期内可使用的最大CPU时间cpu.cfs_burst_us:容器可以借用的额外CPU时间(适用于支持该特性的内核)cpu.cfs_period_us:CPU配额计算的时间周期(默认100毫秒)

4. 实施方案

4.1 阿里云ACK集群启用CPU Burst

在阿里云ACK集群中,可通过以下两种方式启用CPU Burst:

方法一:通过Pod注解配置

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

template:

metadata:

annotations:

koordinator.sh/cpuBurst: '{"policy":"auto","cpuBurstPercent":200,"cfsQuotaBurstPercent":300}'

方法二:通过ConfigMap在集群或命名空间级别配置

apiVersion: v1

kind: ConfigMap

metadata:

name: slo-controller-config

namespace: koordinator-system

data:

colocation-config: |

{

"enable": true,

"cpuBurst": {

"enable": true,

"policy": "auto",

"cpuBurstPercent": 200,

"cfsQuotaBurstPercent": 300,

"sharePoolThresholdPercent": 50

}

}

4.2 主要配置参数说明

| 参数 | 类型 | 说明 |

|---|---|---|

| policy | string | CPU Burst策略,可选值:- none:不启用CPU Burst- cpuBurstOnly:仅启用cpu.cfs_burst_us弹性能力- cfsQuotaBurstOnly:仅启用cfs quota弹性能力- auto:同时启用上述两种弹性能力 |

| cpuBurstPercent | int | cpu.cfs_burst_us的百分比值,默认为100,表示额外增加100%的burst配额 |

| cfsQuotaBurstPercent | int | cpu.cfs_quota_us的弹性百分比值,默认为300,表示最多可弹性扩展到原始配额的300% |

| sharePoolThresholdPercent | int | 节点CPU使用率安全水位阈值(%),超出后会恢复所有调整的配额 |

5. 最佳实践建议

5.1 适用场景

CPU Burst特别适合以下场景:

- 延迟敏感型应用:API网关、数据库代理等对响应时间要求高的服务

- CPU使用波动大的应用:有明显峰谷特征的工作负载

- 启动阶段资源密集型应用:应用在启动时需要更多资源,稳定后资源用量降低

- 具有多线程并发特性的应用:如JVM应用、大数据处理框架等

5.2 使用建议

监控节流指标:通过

cat /sys/fs/cgroup/cpu/cpu.stat检查节流状态nr_periods # 总调度周期数 nr_throttled # 被节流的周期数 throttled_time # 总节流时间(纳秒)操作系统选择:推荐使用Alibaba Cloud Linux操作系统,它提供了更好的内核级CPU Burst支持

资源设置策略:

- 对延迟敏感应用考虑移除CPU限制或设置较高的限制(观察到p99 CPU最大值的2-3倍)

- 结合动态扩缩容(HPA)和垂直Pod自动扩缩(VPA)使用

性能测试:在开启CPU Burst后进行全面的性能测试,特别是在高负载场景下

6. 补充资源优化策略

除了CPU Burst外,Kubernetes提供了多层次的资源优化工具,可根据不同时间尺度的负载变化协同工作:

6.1 KEDA(Kubernetes事件驱动自动扩缩容)

KEDA是一种基于事件的自动扩缩容工具,适合处理以事件或队列为驱动的工作负载。

主要特点:

- 基于外部指标源(如消息队列、事件计数等)进行扩缩容

- 支持从0到N的扩缩容,无负载时可完全释放资源

- 支持多种事件源,包括Kafka、RabbitMQ、Redis、Prometheus等

示例配置:

apiVersion: keda.sh/v1alpha1

kind: ScaledObject

metadata:

name: kafka-scaler

spec:

scaleTargetRef:

name: kafka-consumer

minReplicaCount: 0

maxReplicaCount: 20

triggers:

- type: kafka

metadata:

bootstrapServers: kafka.svc:9092

consumerGroup: my-group

topic: my-topic

lagThreshold: "10"

6.2 VPA(垂直Pod自动扩缩容)

VPA自动调整Pod的CPU和内存请求与限制,提高资源利用率和应用性能。

主要特点:

- 根据历史资源使用情况推荐或自动调整资源配置

- 可以设置不同模式:

Off(仅推荐)、Initial(仅首次设置)、Auto(自动调整) - 适合资源需求相对稳定但初始设置不准确的工作负载

示例配置:

apiVersion: autoscaling.k8s.io/v1

kind: VerticalPodAutoscaler

metadata:

name: my-app-vpa

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment

name: my-app

updatePolicy:

updateMode: "Auto"

6.3 HPA(水平Pod自动扩缩容)

HPA通过调整Pod副本数量应对负载变化,是Kubernetes中最基础的自动扩缩容机制。

主要特点:

- 基于CPU、内存使用率或自定义/外部指标进行扩缩容

- 支持配置最小/最大副本数限制

- 可设置缩放行为(稳定窗口、冷却周期等)

示例配置:

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: my-app-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: my-app

minReplicas: 1

maxReplicas: 10

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 70

6.4 Karpenter(智能节点供应)

Karpenter是一个开源的Kubernetes节点供应工具,最初由AWS开发,但现已支持多种云平台,包括阿里云ACK、腾讯云TKE等环境。

主要特点:

- 快速节点供应,通常不到一分钟内完成

- 实时工作负载感知,根据Pod要求选择最合适的实例类型

- 智能节点合并,减少资源碎片

- 支持多种云平台,不仅限于AWS EKS

示例配置:

apiVersion: karpenter.sh/v1alpha5

kind: Provisioner

metadata:

name: default

spec:

requirements:

- key: karpenter.sh/capacity-type

operator: In

values: ["spot", "on-demand"]

limits:

resources:

cpu: 1000

memory: 1000Gi

ttlSecondsAfterEmpty: 30

在阿里云ACK环境中的集成配置:

apiVersion: karpenter.sh/v1alpha5

kind: Provisioner

metadata:

name: ack-provisioner

spec:

requirements:

- key: node.kubernetes.io/instance-type

operator: In

values: ["ecs.g6e.xlarge", "ecs.g6e.2xlarge", "ecs.g6e.4xlarge"]

- key: topology.kubernetes.io/zone

operator: In

values: ["cn-hangzhou-h", "cn-hangzhou-i"]

provider:

alibabacloud:

vpcId: vpc-xxx

vswitchIds: ["vsw-xxx", "vsw-yyy"]

securityGroupIds: ["sg-xxx"]

tags:

app: "karpenter"

cluster: "ack-cluster"

7. 分层次的资源优化策略

结合CPU Burst和上述工具,可以构建一个多层次的资源优化策略,针对不同时间尺度的负载变化:

| 时间尺度 | 工具 | 应对场景 |

|---|---|---|

| 毫秒级 | CPU Burst | 处理短时突发负载,解决CFS调度导致的节流问题 |

| 秒/分钟级 | HPA | 通过增减Pod副本应对持续几分钟的负载变化 |

| 分钟/小时级 | KEDA | 基于外部事件源(如队列长度)进行更智能的扩缩容 |

| 天/周级 | VPA | 优化长期资源配置,避免资源浪费或不足 |

| 基础设施级 | Karpenter | 智能管理节点资源,提供最适合工作负载的基础设施 |

这种多层次策略能够确保在各种时间尺度上都能高效应对负载变化,既保障应用性能,又优化资源利用率。

8. 性能效果

正确配置CPU Burst及补充策略后,可预期以下改进:

- 响应时间降低:减少因CPU节流导致的延迟高峰

- 吞吐量提升:多线程应用可获得25%-40%的吞吐量提升

- 错误率降低:减少因资源限制导致的超时和错误

- 资源利用率提高:提高集群整体资源利用效率

- 运维成本降低:通过智能资源分配减少基础设施成本

- 稳定性增强:减少容器重启和服务中断

9. 常见问题

9.1 配置后仍有CPU节流

可能原因:

- 配置格式错误,导致策略未生效

- CPU利用率超过

cfsQuotaBurstPercent设置的上限 - 节点整体CPU使用率过高,触发安全阈值保护机制

9.2 是否必须使用Alibaba Cloud Linux?

不是必须的,但推荐使用。Alibaba Cloud Linux内核提供了更完善的CPU Burst支持,特别是在cgroup v1接口上提供了额外的功能增强。

9.3 如何选择合适的自动扩缩容工具组合?

- 对于无状态、CPU密集型应用:CPU Burst + HPA

- 对于事件/队列驱动的应用:CPU Burst + KEDA

- 对于资源需求多变的应用:CPU Burst + VPA + HPA

- 大规模集群环境:以上工具 + Karpenter

10. 参考文档

Lazarev, A. (2025). CPU Limits in Kubernetes: Why Your Pod is Idle but Still Throttled

Musthafa, F. (2020). CPU limits and aggressive throttling in Kubernetes

Stiliadis, D. (2020). Kubernetes Scheduling and Timescales